Täglich wird KI in den aktuellen Schlagzeilen entweder als Allheilmittel gepriesen oder als Vorbote des Untergangs verdammt. Wahlweise wird behauptet, dass der Algorithmus uns sagen kann, wie wir die Probleme der Welt beheben, oder dass er uns bald alle Jobs wegnehmen und gefährlich intelligent wird. Die Wahrheit liegt – wie immer – irgendwo dazwischen. KI wird wahrscheinlich viele positive Auswirkungen haben, die nicht unbedingt die Welt verändern werden, und gleichzeitig negative Folgen nach sich ziehen, die jedoch nicht menschheitsbedrohend sind. Um den goldenen Mittelweg zu finden, sollten Sie die Antworten auf einige interessante Fragen zum angemessenen Einsatz von KI kennen.

1. Können wir KI ohne menschliche Überwachung einsetzen?

Die vollständige Antwort auf diese Frage könnte wahrscheinlich Bände füllen, aber so weit wollen wir nicht gehen. Stattdessen können wir uns auf einen Anwendungsfall konzentrieren, der immer beliebter wird und immer häufiger genutzt wird: generative KI-Assistenten. Wahrscheinlich haben Sie schon ChatGPT oder Bard oder eine der Dutzenden Plattformen genutzt, die jedem Computernutzer zur Verfügung stehen. Wenn Sie diesen Algorithmen Fragen stellen, können Sie dann blind auf die Antworten vertrauen?

Die kurze Antwort lautet: “Nein”. Die Chatbots sind durchaus zu Halluzinationen fähig, d. h. die KI kann Antworten “erfinden”. Die gelieferten Antworten stammen aus den Trainingsdaten des Algorithmus, lassen sich aber möglicherweise nicht auf reales Wissen zurückführen. Nehmen wir den aktuellen Fall eines Anwalts, der in einem Gerichtsverfahren Unterlagen einreichte, die er mithilfe von ChatGPT erstellt hatte – und die KI hatte nicht existierende Präzedenzfälle zitiert, um die Position zu begründen.

In Bezug auf KI wird menschliche Überwachung wahrscheinlich immer notwendig sein. Ganz gleich, ob ein Modell das Wetter analysiert, um Regen vorherzusagen, oder ein Geschäftsmodell bewertet: Es können sich immer noch Fehler einschleichen oder logisch nicht sinnvolle Antworten ausgegeben werden. Beim angemessenen Einsatz von KI ist ein menschlicher Faktenprüfer notwendig. Das gilt ganz besonders bei ChatGPT und ähnlichen Tools.

2. Können KI-Entwickler algorithmische Verzerrungen nachträglich korrigieren?

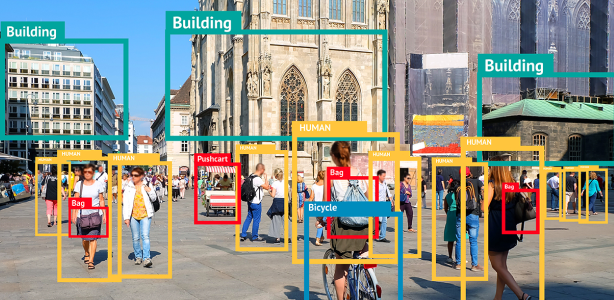

Auch diese Frage ist so kompliziert, dass sie hier nicht vollständig beantwortet werden kann. Wir können jedoch an dieser Stelle einen engeren Anwendungsfall untersuchen. Bedenken Sie, dass bei vielen KI-Algorithmen in der realen Welt diskriminierendes Verhalten festgestellt wurde. Bei einer KI beispielsweise war die Fehlerquote je nach Geschlecht oder Rasse der Probanden wesentlich höher. Eine andere stufte das Risiko von Gefangenen falsch ein, was zu unverhältnismäßig hohen Rückfallquoten führte.

Können diese Probleme denn beseitigt werden, nachdem das Modell in Betrieb genommen wurde? Ja, die Entwickler können den Code auch nach der Veröffentlichung der Modelle jederzeit überprüfen und anpassen. Die Evaluierung und Prüfung ist jedoch mitunter ein kontinuierlicher Prozess. Die KI-Entwickler können sich stattdessen darauf konzentrieren, im Entstehungsprozess ihrer Modelle Werte zu reflektieren.

Die Ergebnisse von Algorithmen sind nur so zuverlässig wie die Daten, mit denen sie trainiert wurden. Wenn ein Modell mit einer Datenpopulation trainiert wird, die die zu analysierenden Daten nicht gut widerspiegelt, werden diese inhärenten Verzerrungen im Live-Modell deutlich. Aber auch bei sehr zuverlässigen Modellen fehlt immer noch das grundlegende menschliche Verständnis dafür, was richtig oder falsch ist. Zudem kann es wahrscheinlich nicht feststellen, ob ein Benutzer böse Absichten hat.

Die Entwickler können nach der Erstellung ihrer Modelle zwar noch Änderungen vornehmen, im Idealfall konzentrieren sie sich jedoch vom ersten Tag an auf die Werte, die die KI berücksichtigen soll.

3. Wer ist für die Aktionen einer KI verantwortlich?

Vor einigen Jahren fuhr ein autonomes Fahrzeug eine Fußgängerin an und verletzte sie tödlich. Die zentrale Frage lautete: “Wer war für den Unfall verantwortlich?” War es Uber, da es ein Uber-Auto war? War es die Fahrerin des Wagens? In diesem Fall wurde die Fahrerin des Fahrzeugs, die im Auto saß, wegen Gefährdung im Straßenverkehr angeklagt. Doch was wäre, wenn das Auto leer und völlig autonom gefahren wäre?

Was wäre, wenn ein autonomes Auto einen Fußgänger nicht erkennen würde, der bei Rot über die Straße geht? Schließlich hat die Ampel das richtige Signal gezeigt! Da KI in immer mehr öffentlichen Bereichen Einzug hält, stellt sich immer dringender die Frage nach der Verantwortung. Einige Rechtssysteme (wie die EU) arbeiten an Gesetzesrahmen, die die Strafbarkeit von KI regeln. Diese Vorschriften werden versuchen, “je nach dem Grad des Risikos, das durch die KI entsteht, unterschiedliche Verpflichtungen für Anbieter und Nutzer” festzulegen.

Es liegt in unser aller Interesse, beim Einsatz von KI so vorsichtig wie möglich zu sein. Die Fahrerin des autonomen Autos hätte zum Beispiel mehr auf die Straße achten müssen. Menschen, die Inhalte in sozialen Medien teilen, sollten genauer überprüfen, ob es sich bei den geteilten Inhalten um Deepfakes oder eine andere Form von KI-generiertem Inhalt handelt.

4. Wie können wir die Vorteile von KI nutzen, ohne dass Sicherheit und Datenschutz leiden?

Dies ist wahrscheinlich die drängendste Frage in Bezug auf die angemessene Nutzung von KI. Jeder Algorithmus muss mit großen Mengen an Trainingsdaten entwickelt werden. Wenn das Modell zum Beispiel das Verhalten realer Personen bewerten soll, um Betrug zu erkennen, sollte das Training mithilfe von Informationen aus der realen Welt erfolgen. Wie können Unternehmen sicherstellen, dass die von ihnen verwendeten Daten nicht gestohlen werden? Woher wissen Benutzer, welche Informationen sie preisgeben und für welche Zwecke sie verwendet werden?

Diese große Frage lässt sich unterteilen in kleinere, spezifischere Fragen, die versuchen, zum Kern der Sache vorzudringen. Bei Benutzern dreht sich letztendlich alles darum, ob sie darauf vertrauen können, dass das Unternehmen ihre Daten zu einem zulässigen Zweck bzw. auf sichere Weise nutzt.

5. Benutzer müssen aktiv werden, um die angemessene Nutzung ihrer Daten zu gewährleisten

Benutzer, die sich darum sorgen, dass ihre Daten vielleicht für KI-Training verwendet werden oder aus anderen Gründen gefährdet sind, können einige Maßnahmen ergreifen. Zunächst einmal können sie beim Surfen im Internet immer wählen, ob Cookies gespeichert werden dürfen. Seitdem die DSGVO und der California Consumer Privacy Act (CCPA) in Kraft getreten sind, muss praktisch jedes Unternehmen, das in den USA oder der EU tätig ist, auf seiner Website darüber informieren, dass es Informationen zum Surfverhalten erfasst. Wenn Sie hier die richtige Auswahl treffen, können Sie verhindern, dass Unternehmen Informationen ohne Ihr Einverständnis verwenden.

Die zweite Möglichkeit ist die Nutzung von Drittanbieter-Tools wie McAfee+, die Dienste wie VPNs, Datenschutz und Identitätsschutz als Teil einer umfassenden Sicherheitsplattform anbieten. Der vollständige Schutz vor Identitätsdiebstahl bietet eine zusätzliche Sicherheitsebene, die Ihre Wahl der Cookie-Einstellungen und Ihre anderen sicheren Surfgewohnheiten ergänzt. Verlassen Sie sich nicht blind darauf, dass Ihre Daten angemessen genutzt werden. Schützen Sie sie aktiv.