はじめに

現在は、学校の教室でも、会社の役員室でも、夜のニュース番組でも、家族で囲む食卓でも、人工知能 (AI) の話題で持ちきりです。これほど注目されている AI はまったくの新しい技術だと思うかもしれませんが、実際には数十年前からさまざまな形で存在していました。以前との違いは、現在ではほぼすべての人が AI を利用できるようになったという点です。AI を活用して、メールの文章を改善したり、インスピレーションを得たり、生産性を高めたり、楽しいミームを作ったりすることができます。AI が生成したからという理由だけで、それが有害なものであるということにはなりません。

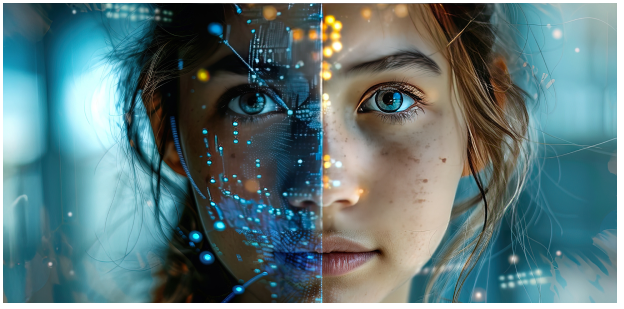

ディープフェイクとは、AI によって生成されたメディアの産物であり、特定の人物の表情や声を表現するものです (まったく架空の人物を表現している場合もあります)。

自分の声でポッドキャストを作成したり、歴史について解説する動画を作成したりなど、ポジティブな目的でディープフェイクを使用することができます。

しかし、このツールが悪意をもって使用されたらどうなるでしょうか。その場合、ディープフェイクは危険なものになってしまいます。ディープフェイクを使用すると、簡単に偽の情報を信じ込ませることができます。

このガイドでは、ディープフェイク AI の現状と、ディープフェイクに騙されないようにする方法について説明します。

ディープフェイクとは

現在はソーシャル メディアとバイラル ビデオの時代ですが、オンラインで目にするものを信用することがますます難しくなっています。ディープフェイクで作成された動画や画像は信じられないほどリアルに見えますが、実際には AI によって巧妙に操作されたものです。

あなたの好きな有名人が実際には撮影されていない映画に出演したり、政治家が実際にはしていない演説をしたりする場面を想像してみてください。それがディープフェイクの力です。ディープフェイクは、既存の動画や写真を使用して作成されます。AI を活用して顔や声を変えたり、実際には言ったこともやったこともないことを、その人物に言わせたりやらせたりすることができます。

無害で面白いディープフェイクもありますが (人間の代わりに猫が話しているような動画など)、ダークな側面を持つディープフェイクもあります。誤った情報を広めたり、選挙を操作したり、評判を落とすような目的で使用されることがあります。そのため、批判的な視点をもってメディアを活用し、できすぎていると感じるような情報を拡散する前によく考えることが重要になります。

ChatGPT、Google Bard、Sora などの生成 AI ツールを使用すれば、テキスト、アート、動画だけでなく、人間のスピーチも模倣することができます。このように技術は進歩していますが、ディープフェイク AI をどのように使用すべきかという倫理観については、まだ初期段階にすぎません。

有害なディープフェイクが与える影響の例をいくつか紹介します。

- ある有名人の知らないところで、その有名人が商品を推薦しているディープフェイク動画が拡散され、その動画を見た人がその商品を購入して無駄なお金を使ってしまう。

- ある政治家の演説を改変したディープフェイクのオーディオ クリップを聞いた人が、その政治家に対する支持/不支持の意見を大きく変えてしまう。

- 誤解を招くようなビデオ クリップが簡単に拡散され、ビデオ内の事実はまったく存在しないにもかかわらず、結果として誤った情報が広がってしまう。

- AI による音声シミュレーションはソーシャル メディア上で人気があるため、有名人や政治家などの公人をネタにしたジョークのオチに使用されることが多い。

- AI によるその他の音声詐欺として、電話や音声テキスト メッセージを使用して、経済的な支援を必要としている友人などの声を模倣してターゲットをだまそうとするケースがある。

こうした詐欺に対処するには、詐欺の仕組みを理解することが重要です。最新情報を常に把握することにより、偽のメディアを見抜く力がつき、だまされる可能性が低くなります。

ディープフェイクの仕組みを理解する

ディープフェイクとは、「ディープラーニング」と「フェイク」を組み合わせた造語で、既存の画像や動画に写っている人物を巧妙に操作して置き換えた高度なデジタル生成物のことです。これは、強力な人工知能と機械学習技術を活用して動画の内容を改変し、実際には起こっていないことを事実のように提示する技術です。ここでは、ディープフェイクの作成方法とその技術について詳しく説明します。

- データ収集

ディープフェイクを作成するための最初のステップは、模倣する人物のビジュアルと音声に関する十分なデータを収集することです。通常、さまざまな照明や角度からの表情が撮影されている多数の画像や動画を収集する必要があります。こうして収集したデータを使用して AI モデルのトレーニングを行い、ターゲットの表情や声の特徴を理解してそれを再現します。 - 機械学習モデル

ディープフェイク技術の中核となるのは、オートエンコーダや敵対的生成ネットワーク (GAN) と呼ばれる機械学習モデルです。オートエンコーダーは、データを密度の高い小さな表現に圧縮し、それを元の形に展開する方法を学習します。ディープフェイクの場合、オートエンコーダーを使用して画像などの高次元データを低次元のコードに縮小し、次にそのコードを画像として拡張すると、顔を入れ替えることができます。

GAN は、生成機能と識別機能という 2 つの部分から構成されています。生成機能によって画像が作成され、識別機能によって画像が評価されます。時間の経過とともに、生成機能は精度の高い偽物を作成する方法を学習し、識別機能は偽物を見分ける能力を高めていきます。この敵対的プロセスによって生成物の品質が向上し、ディープフェイクがよりリアルなものになります。 - モデルのトレーニング

収集したデータを使用して、AI モデルのトレーニングを行います。このプロセスでは、ターゲットの顔や声の特徴を高い精度で再現できるようになるまで、ニューラル ネットワークのパラメーターが調整されます。ディープフェイク モデルのトレーニングには非常に大きな計算能力が必要になるため、データの複雑さや求める生成物の品質にもよりますが、トレーニングには数日から数週間かかる場合があります。 - 動画作成

モデルを十分にトレーニングしたら、そのモデルを使用してディープフェイク動画を作成します。このプロセスでは、特定の人物の顔や声を置き換える動画や画像を入力データとしてモデルに渡します。その後、AI が入力データを処理し、学習した人物の顔や声の特徴を動画内で入れ替え、本物に見えるシームレスなフェイクを作成します。 - 仕上げ

最初の生成物には、不自然なまばたきや唇の動き、表情のぎこちなさなど、不完全な部分が残っている場合があります。ビデオ編集ツールを使用して後処理と編集を行うことにより、これらの欠点を修正し、よりリアルな動画に仕上げます。

ディープフェイクの一般的な用途

ディープフェイクは、有益な目的か悪意のある目的かにかかわらず、さまざまな分野でますます使用されるようになっています。エンターテインメント分野ではリアルな特殊効果を生み出すために使用され、教育分野では魅力的なコンテンツを生成するために使用されていますが、サイバー犯罪者は詐欺や誤った情報を発信する目的で使用しているため、倫理面とセキュリティ面で大きな課題になっています。ここでは、最も一般的でインパクトのあるディープフェイクの使用例を紹介します。

- エンターテインメントとメディア

エンターテインメント分野では、印象的な効果を生み出す目的でディープフェイクが使用されています。映画制作者や映像プロデューサーは、ディープフェイク技術を活用して俳優の見た目を若くしたり、亡くなった俳優の演技を復活させたり、映画やテレビ番組の視覚効果を高めたりしています。この技術により、創造性と柔軟性を高め、従来の映画製作の限界を押し広げることができます。 - コンテンツのパーソナライズ

ディープフェイクにより、マーケティングや広告のコンテンツをパーソナライズすることができます。たとえば、CM で有名人のディープフェイク バージョンを使用し、その有名人にさまざまな言語で話をさせることにより、多様な視聴者が親しみやすいコンテンツにすることができます。同様に、ディープフェイクでパーソナライズされたビデオ メッセージを使用すれば、顧客に対して独自のエクスペリエンスを提供し、エンゲージメントと顧客ロイヤルティを高めることができます。 - 教育とトレーニング

教育分野では、ディープフェイクを使用してインタラクティブな学習体験を提供することができます。たとえば、歴史上の人物を登場させて、その人物の人生や時代について講義をしたり、著名な科学者が複雑な理論について説明した場合にはどうなるでしょうか。これは特に視覚的に訴えるため、学習がより身近で魅力的なものになります。 - アート作品と社会問題に対する言及

アーティストや活動家は、ディープフェイクを活用して、インスピレーションを刺激するアート作品や社会問題に対する言及を行っています。ディープフェイクを使用して、実際の出来事の改変や再構築を行うことにより、視聴者の認識を覆し、現実、技術、倫理についての再考を促すことができます。多くの場合、こうしたコンテンツの目的は、ディープフェイク技術の潜在的な危険性を浮き彫りにすると同時に、その芸術的な可能性を探ることです。 - 研究開発

研究者は、心理学や顔認識技術などの分野でディープフェイクを活用しています。さまざまな表情、動作、シナリオを生成して、人間の行動、感情反応、多様な条件下での顔認識システムの有効性を研究しています。

ディープフェイク技術の誕生

ディープフェイク技術は、機械学習と人工知能の進化、特にディープ ニューラル ネットワーク分野の進化によって誕生しました。これらの技術は、当初は画像認識や言語処理を改善する目的で開発されましたが、その後は、リアルな合成メディアを作成する目的で使用されるようになりました。その結果、実在の人物を模倣した精度の高い動画や音声を作成できるようになりました。

ディープフェイク技術は、2017 年頃に「DeepFakes」という仮名を名乗る開発者が、有名人のリアルな偽アダルト動画を Reddit に投稿し始めたことがきっかけとなって世間に認知されるようになりました。これはメディアの注目を広く集めただけでなく、使いやすいディープフェイク作成ソフトの開発にもつながりました。FakeApp などのツールや高度なアプリケーションにより、専門的知識がない一般的なユーザーでもディープフェイクを作成できるようになり、ディープフェイクへの参入障壁が大幅に下がりました。

ディープフェイクが危険な理由

ディープフェイクがもたらす最も重大なリスクの 1 つは、信頼が徐々に失われるということです。技術の進化に伴い、何が本物で何が偽物かを見極めるのがますます難しくなっています。

偽の情報

ディープフェイクに対して疑念を抱くようになると、オンライン上で目にしたり耳にしたりすることを信じられなくなります。こうした疑念が高まってくると、オンライン上の情報をどのように活用し、メディアとどのように接するかに大きく影響するようになります。ディープフェイクがより巧妙になると、個人ユーザーだけでなく、コミュニケーションやマーケティング活動をデジタル メディアで行っている組織にとっても、本物のコンテンツと偽物のコンテンツを区別することがますます難しくなります。その結果は非常に重大なものになる可能性があります。自分で意識することなくデマを拡散したり、そうしたデマに反応して混乱を引き起こしたり、自分や他人の名誉を傷つけたりする可能性があります。

また、ディープフェイクの蔓延により、正当なニュース ソースに対する人々の信頼が失われることも考えられます。偽のコンテンツによる被害に遭うことへの警戒心が強くなると、正しい情報に対する不信感も高まるため、正しい情報にもかかわらず信頼されないというリスクが大きくなる可能性があります。

こうした問題に対処するには、技術開発者、政策立案者、メディア組織が協力して、ディープフェイク コンテンツを検出して警告できるように取り組むことが非常に重要です。キャンペーンを通じてディープフェイクの存在と危険性について啓発することにより、ユーザーは自分が利用するメディアを批判的に評価できるようになります。

プライバシーの侵害

現在はデジタルの時代ですが、こうした時代にディープフェイク技術が出現したという事実は、プライバシーの侵害について新たな側面が発生したことと、倫理観と法順守に関する独自の課題に取り組む必要があることを示しています。ある人物の特徴を別の人物の特徴に置き換えた合成メディアであるディープフェイクは、ますます高度になって簡単に利用できるようになっているため、個人のプライバシー権に対する重大な懸念を引き起こしています。

たとえば、ある日目を覚ましたときに、自分が言ったこともやったこともない内容の動画がネット上に公開されているのを目にした場面を想像してみてください。これはもはや SF の世界の話ではありません。多くの人にとって、これは不快な現実です。ディープフェイクの被害者は、重大なプライバシーの侵害を経験することが多く、その心理的な影響は深刻で、苦痛や無力感を覚えることがあります。

政治的な混乱

信頼と信用が最も重視される政治の世界では、ディープフェイクは大きな混乱を引き起こす強力なツールとして登場しました。視覚的にも音声的にも非常にリアルなディープフェイクは、人々に誤った認識を与えて論争を巻き起こし、選挙にも影響する可能性があります。その影響は甚大で、政治家個人だけでなく政局全体にまでおよびます。

ディープフェイクを使用して、ターゲットとなる政治家の性格に合っていない発言や、まったく虚偽の発言をさせることにより、その政治家の評価が大きく低下する可能性があります。このような信頼感の低下は、ターゲットにされた政治家個人だけでなく、政治全体に対する国民の信頼を失うことにつながります。有権者が目にしたり耳にしたりしたことを信用できなくなると、民主主義に必要な基礎的な信頼感の崩壊が始まります。

金融詐欺

ディープフェイク技術は、金融詐欺に利用される場合があります。AI によるボイス クローニングを組み合わせた電話でのフィッシング攻撃は、これまで以上に信憑性を増しています。詐欺師はディープフェイク技術を活用して、ターゲットにとって大事な人物の声を模倣し、重要な個人情報を聞き出そうとしたり、金銭をだまし取ろうとしたりします。こうした詐欺の場合、金銭的にも精神的にも大きな被害を被る可能性があります。

広告で使用されるディープフェイクの場合、個人の幸福の脅威になることは少ないですが、経済的な被害を受ける可能性があります。詐欺師は、架空の推薦文を作成して権威のある人物になりすますことにより、疑うことを知らない消費者から金銭を得ようとします。詐欺師がなりすました人物も、評価を落とすことになります。

参照リソース

- https://www.mcafee.com/ai/news/this-election-season-be-on-the-lookout-for-ai-generated-fake-news.html

- https://www.mcafee.com/ai/news/mcafee-joins-tech-accord-to-combat-use-of-ai-in-2024-elections

- https://www.mcafee.com/ai/news/deepfake-defense-your-8-step-shield-against-digital-deceit

ディープフェイクから身を守る方法

ディープフェイク AI の脅威は広がっていますが、それを防ぐのは不可能なことではありません。AI が生成した動画コンテンツに伴うリスクから身を守ることは、現在のデジタル環境において非常に重要なことです。ここでは、リスクを避けるための 6 つの重要な方法を紹介します。

- 必要な情報を得る: AI 技術、特に動画生成技術に関する最新情報を得ることが重要です。ディープフェイクなどの AI 生成コンテンツがどのように作成されるのかを理解すると、その潜在的な影響を認識してリスクを軽減できるようになります。

- ソースを確認する: 必ず、動画のコンテンツのソースを確認するようにしてください。不審に感じたり、うまくできすぎていると感じるようなことがあれば、それを信じて拡散する前に、十分に注意する必要があります。

- 信頼できるプラットフォームを使用する: 可能な限り、信憑性と信頼性を重視しているソースやプラットフォームの動画コンテンツを視聴するようにしてください。ソーシャル メディアやあまり知られていない Web サイト上の動画を視聴する場合は、注意する必要があります。

- 個人情報を保護する: ビデオ通話やメッセージング プラットフォームで個人情報を共有したりプライベートな会話をしたりする場合は、慎重になる必要があります。自分の個人情報を教える前に、相手の身元情報を確認するようにしてください。

- 新しい技術に関する最新情報を入手する: AI を利用した詐欺が増えていますが、それに対処する技術も進化しています。

- 法律と規制を把握する: ディープフェイクの使用に関する具体的な法律はまだ流動的な状態ですが、中国などの一部の国では、ディープフェイクで特定の人物の顔を使用する前に、その人から明確な同意を得ることを義務付けています。AI やディープフェイク技術を責任を持って使用するためのガイドラインを確立することを目的として、同様の取り組みが世界各国で行われています。

ディープフェイクの例

悪質なディープフェイクが急速に広まっているため、ディープフェイク詐欺と戦うことを目的として、オンライン上で見つかったディープフェイクを共有するためのページを作成しました。

ここでは、ディープフェイクの実例をいくつか紹介します。政治、エンターテインメント、金融の各分野におけるディープフェイク詐欺の影響を確認してください。

2020 年に、ナンシー・ペロシ下院議長 (当時) のディープフェイク動画が拡散されたことがありました。この動画は、ペロシ議長がろれつが回っていない話し方をしているように加工されていたため、ディープフェイク技術が政治的操作に悪用される可能性があるという懸念が起こりました。この出来事は、うまくできすぎていると感じるような動画には懐疑的になる必要があり、オンライン コンテンツの信憑性を評価する際には、動画の品質とソースを確認すべきだという注意喚起になりました。

ディープフェイクは、誤った情報を広めるという目的でも利用されてきました。最初の米国大統領予備選を目前に控えた 2024 年 1 月に、ニューハンプシャー州の有権者数千人に対してバイデン大統領のディープフェイク ロボコールが発信されました。その内容は、「11 月の本選挙に向けて、予備選には投票しないように」と有権者に呼びかけるものでした。このような活動を放置すれば、選挙結果が混乱する可能性があります。

エンターテインメント業界でも、AI で有名人のクローンを作成して商品を売るというディープフェイク詐欺が大きな問題になっています。2024 年初頭に、ファンに対して「調理器具を無料でプレゼントします」と語りかけるテイラー・スウィフトの動画が拡散されました。しかし、これを信じて情報を提供した視聴者は、個人情報の盗難被害に遭ってしまいました。ケリー・クラークソン、トム・ハンクス、ヒュー・ジャックマンといった有名人も、同様の詐欺で利用されています。

また、リアルな視覚効果を生み出したり、亡くなった俳優を生き返らせたりする場合にも、ディープフェイクが使用されてきました。たとえば、2016 年公開の映画『ローグ・ワン/スター・ウォーズ・ストーリー』では、グランド・モフ・ターキンを再現するために故ピーター・カッシングのディープフェイクが使用されました。こうしたディープフェイクの使用は、現実とフィクションの境界線を曖昧にし、ディープフェイク技術の使用における倫理観という問題を提起しています。

ディープフェイクを見抜く方法

ディープフェイクを見抜くには、細部まで注意する鋭い観察眼が必要になります。本物と偽物を見分けるための重要な方法をいくつか紹介します。

- 顔の特徴を詳しく見る: ディープフェイクの場合、人物の目が不自然に見える例が多くあります。不自然なまばたきや目の動き、目と唇の動きが一致していないなど、表情の不自然な部分に注意してください。また、肌の色や質感にも注意する必要があります。ディープフェイクでは、肌の色が急激に変化したり、肌が不自然に滑らかになったりすることがあります。

- 背景に注意する: ディープフェイク動画では、人物と背景を自然な形で組み合わることが難しい場合があります。照明、影、遠近法などに不自然な部分がないかを確認してください。人物が背景から浮いて見えたり、離れて見えたりしていないか、カメラが動いたときに背景が急に変化していないかなどに注意してください。

- 一致しない音声に注意する: ディープフェイク動画には、唇の動きとまったく一致しない音声が含まれている場合があります。音声に不自然な間がないか、トーンが不自然に変化していないか、音声が不自然に歪んでいないかなどを確認してください。また、人物の声がロボットのように聞こえたり、抑揚や感情が欠けているように感じることもあります。

- 全体的な品質に注意する: ディープフェイク動画は、本物の動画に比べて品質が低い場合が多くあります。解像度、ぼやけ、不自然な動きなどに注意してください。ディープフェイクには AI が生成したコンテンツの特性があるため、人工的な外観になる場合もあります。

- ディープフェイク AI 検出ツールを使用する: ディープフェイクを検出するために特別に設計されたオンライン ツールやソフトウェア アプリケーションがあります。これらのツールには、動画を分析して潜在的な加工を識別するための高度なアルゴリズムが組み込まれています。これらのツールですべてのディープフェイクを検出できるわけではありませんが、ディープフェイクに対する保護能力は高くなります。

常にディープフェイクに注意し、ここで紹介した方法を実践することにより、ディープフェイクを見抜く能力を高め、誤った情報から身を守ることができるようになります。

うまくできすぎていると感じるような場合は、細部まで注意して真偽を確認することを忘れないでください。

参照リソース

ディープフェイクを検出するための手段法

ディープフェイクはますます巧妙になっているため、肉眼で見分けるのが難しくなっています。ディープフェイクに対処する手段として、音声とビジュアルの不整合分析機能、AI ベースの検出アルゴリズム、デジタル アーティファクトの検証機能など、さまざまな技術が開発されてきました。これらの技術は、加工されたコンテンツを識別し、デジタル メディアの信頼性を維持する上で非常に重要なものです。

ディープフェイクにだまされないようにするためのヒント

ディープフェイクがさらに進化して広がっている現在、ディープフェイクにだまされないように身を守ることが非常に重要です。ここでは、ディープフェイクにだまされないようにするための実践的なヒントを紹介します。

- 批判的な目を持つ: 非常に洗練された動画や、うまくできすぎているように感じる動画には注意する必要があります。ディープフェイク動画の場合、人物の動きが不自然だったり、細かい点が本物の動画とは異なっていることがよくあります。

- 動画の品質に注意する: 動画の品質を詳しく確認することが重要です。動作が不自然ではないか、照明と影がずれていないか、背景の細かい部分が欠けていないかなどに注意すると、ディープフェイクに気付く場合があります。

- ソースを確認する: 必ず動画のソースを確認してください。ソースが、信頼できる報道機関、評価の高い Web サイト、有名なソーシャル メディア アカウントかどうかを確認する必要があります。知らないソースや疑わしいソースの場合は、注意する必要があります。

- テキストに注意する: 通常、AI による偽物が単独で動画に登場することはありません。多くの場合、偽物の周囲にテキストや大きな記事が配置されます。テキストに誤字や脱字はないか、文法はおかしくないか、全体的な文章に問題はないかを確認してください。意味のある文章になっているかどうかについても確認する必要があります。さらに、正当なニュース記事と同様に、発行日時、発行場所、著者名などが記載されているかどうかを確認してください。

- 主張内容を検討する: 現実とは思えない内容になっていないかどうかに注意してください。本当にしてはできすぎていると感じる場合は注意が必要です。「インターネットで読んだことは何も信じるな 」という言葉をよく聞きますが、これには「インターネットで目にしたものは何も信じるな 」という意味も含まれています。正しいかどうか疑わしいニュースについては、別の場所で同じような見出しのニュース記事を検索してください。本当に注目すべきニュースであれば、別の有名なサイトでもそのニュースについて扱い、独自のファクトチェックを行っているはずです。

- 人物の動作や表情に注意する: AI 技術で作成されたフェイク動画の大半は、手や指の動きがぎこちないものになります。生気のない死んだような目になっていたり、両目の間隔が一致していなかったりする場合もよくあります。また、不自然な場所に影ができる場合もあります。さらに、肌の色が均一になっていないこともあります。ディープフェイク動画では、人物の声と表情が正確に一致しておらず、ロボットのようなぎこちない動作になる場合があります。

- ディープフェイク AI 検出ツールを活用する: 現在は、ディープフェイクを検出するためのソフトウェア ツールが開発されています。これらのツールには、動画を分析して潜在的な加工を識別するための高度なアルゴリズムが組み込まれています。

- 積極的に情報を収集する: ディープフェイク技術とその進化に関する最新情報を常に入手することが重要です。ディープフェイクの作成方法とディープフェイクを見抜く方法を理解すれば、適切な情報に基づいてオンライン コンテンツの真偽を判断できるようになります。

参照リソース

- https://www.mcafee.com/ai/news/staying-safe-in-the-age-of-ai/

- https://www.mcafee.com/ai/news/safer-ai-four-questions-shaping-our-digital-future/

- https://www.mcafee.com/ai/news/artificial-intelligence-and-winning-the-battle-against-deepfakes-and-malware/

- https://www.mcafee.com/ai/news/10-artificial-intelligence-buzzwords-you-should-know/

- https://www.mcafee.com/ai/news/how-to-protect-your-privacy-from-generative-ai/